网页抓取API与传统数据抓取的核心区别

2025-10-22

在做数据采集时,你是否也遇到过这样的烦恼——代码逻辑没问题,却总是抓不到完整数据?

网站数据抓取保护升级、请求被停、验证码层出不穷……传统的数据抓取方式似乎越来越吃力。

这时,网页抓取API的优势就显现出来了。借助IPIDEA网页抓取API,你无需再为代理变更、浏览器指纹或停用策略头疼,它能自动应对各种复杂网页结构与数据抓取保护机制,让数据抓取更稳定、更高效。

一、传统数据抓取的HTTP代理

早期的数据抓取主要依赖自建数据抓取程序,通过发送HTTP请求、解析HTML代码、提取目标信息来实现。但这种方式虽然灵活,却存在明显的局限:数据抓取保护机制经常触发:网站会检测访问频率、请求头、IP来源等,一旦识别为自动化行为,就可能不给访问。维护成本高:网站结构或页面格式一旦更新,数据抓取HTTP代理就需要重新调整,维护复杂且耗时。

IP停用与访问失败率高:固定IP访问容易被过滤,需要经常变更代理才能继续抓取。

数据质量不稳定:抓取结果可能出现缺失、重复或解析错误,影响后续分析。

二、网页抓取API智能的解决方案

相比之下,网页抓取API将复杂的代理管理、数据抓取保护处理和数据解析过程打包成简单的API接口,让开发者能够专注于数据应用而非技术实现。

1.开箱即用的解决方案

IPIDEA网页抓取API提供了一种开箱即用的体验,用户只需通过简单的API调用,

即可获取所需的目标网站数据。它内置了全球代理IP资源、智能数据抓取保护应对机制和自动化解析功能,省去了搭建和维护复杂抓取架构的麻烦。

2.智能应对数据抓取保护措施

IPIDEA网页抓取API具备强大的数据抓取保护应对能力,能够自动处理验证码识别、JavaScript渲染、IP轮转等关键挑战。

其动态住宅代理网络可以模拟真实用户行为,大幅降低被目标网站停用的风险。

3.结构化数据输出

与传统数据抓取返回原始HTML不同,IPIDEA的网页抓取API能直接返回结构化的JSON数据。

这意味着开发人员无需再编写复杂的解析逻辑,而是可以直接利用清洗过的数据,大大减少了前期处理工作。

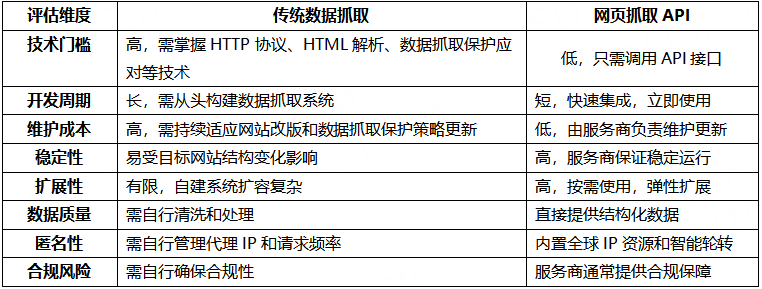

三、网页抓取API与传统数据抓取的核心区别

四、谁更适合使用网页抓取API?

对于需要大规模、持续采集数据的企业或团队,网页抓取API是理想选择。

与其花费大量人力维护传统数据抓取,不如将精力集中在数据分析与应用上,让API自动完成抓取任务。它尤其适用于以下场景:

电商平台的价格与库存监控;

竞争对手网站内容监测与产品对比;

新闻媒体内容采集与舆情分析;

搜索引擎结果页(SERP)抓取;

AI模型训练所需数据采集。

五、总结

传统数据抓取方法由于其高维护成本、技术复杂性和有限的扩展性,已难以满足现代企业的需求。

网页抓取API代表了一种更先进、更高效的数据采集范式,它将复杂的技术挑战转化为简单的API调用,让企业能够专注于数据价值挖掘而非技术实现细节。

IPIDEA的网页抓取API让数据采集更智能、更稳定,也大幅降低了技术与维护成本。

声明:本文来自网络投稿,不代表IPIDEA立场,若存在侵权、安全合规问题,请及时联系IPIDEA进行删除。

下一篇:数据抓取为何常遇IP访问受阻?

美国

美国

英国

英国

加拿大

加拿大

泰国

泰国

印度

印度

韩国

韩国

马来西亚

马来西亚

印度尼西亚

印度尼西亚

更多地区

更多地区