网络爬虫的基本结构及工作流程

作者:IPIDEA

2020-09-26 15:57:45

什么是网络爬虫,基本的工作流程是什么?大量的数据散落在互联网中,要分析互联网上的数据,需要先把数据从网络中获取下业,这就需要网络爬虫技术。网络爬虫是捜索引擎抓取系统的重要组成部分。爬虫的主要目的是将互联网上的网页下载到本地形成一个或联网内容的镜像备份。

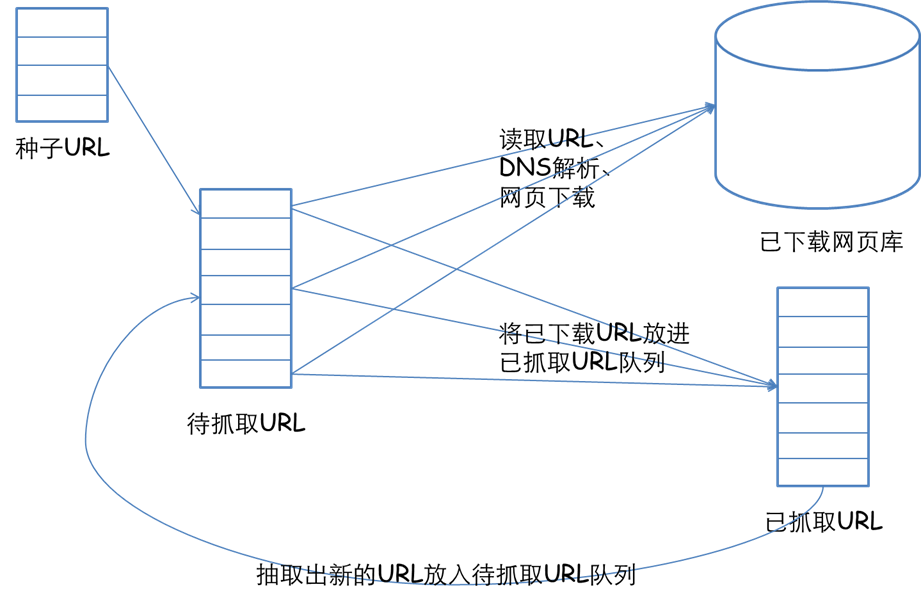

网络爬虫的基本工作流程:首先选取一部分精心挑选的种子URL;将这些URL放入待抓取URL队列;从待抓取URL队列中取出待抓取在URL,解析DNS,并且得到主机的ip,并将URL对应的网页下载下来,存储进已下载网页库中。使用网络爬虫爬取数据,同一个IP频繁操作,必然会导致IP安全性低,无法高效采集公开数据,所以在做爬虫之前,记得使用安全稳定的代理ip比如覆盖全球ip资源的IPIDEA来解决。

此外,将这些URL放进已抓取URL队列。分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL放入待抓取URL队列,从而进入下一个循环。

一个通用的网络爬虫的框架如图所示:

*ipidea提供的服务必须在境外网络环境下使用